生成AIで逮捕される時代に突入した今私たちが知っておくべきこと

生成AIとは、人間のような自然な文章を生成したり、画像や音声を作り出したりする高度なAI技術のことを指します。

近年ではChatGPTや画像生成AIのStable Diffusionなどが一般に普及し、ビジネスから個人利用まで幅広く活用されています。

しかし、この画期的な技術が「悪用」されるケースも増え、ついに逮捕者が出るほどの深刻な社会問題となっています。

実際に、日本国内でも生成AIを使って犯罪行為に関与したとして、逮捕された事例が複数報告されています。これは単なる技術的な問題ではなく、私たち全員が直面する法的リスクとモラルの課題を示しています。

生成AIによって作成されたわいせつ画像の販売や、AIを使ったウイルス作成、不正アクセスによる情報窃盗など、これまで「専門知識がないとできない」と思われていた犯罪行為が、誰でも簡単に実行可能な時代になっているのです。

特に注目すべきは、未成年者やITスキルが乏しい人でも、生成AIの力を借りて高度なサイバー犯罪を行えるようになったという点です。

これにより、社会的な被害の広がりだけでなく、逮捕されるリスクを理解していない若者の誤った行動が加速する恐れもあります。

この記事では、実際の逮捕事例を紹介しながら、なぜ生成AIがここまで問題視されているのか、そして今後どのように向き合っていくべきかを詳しく解説していきます。

技術は使い方次第で便利にも危険にもなり得ます。

だからこそ今こそ、私たちは「生成AI時代の新しいモラルと法律」を理解し、自らを守るための知識を備える必要があるのです。

初の全国摘発となった生成AIわいせつ画像販売事件の衝撃

2025年4月、生成AIを用いたわいせつ画像の販売で4人が逮捕されたというニュースが全国を駆け巡りました。

これは日本において、生成AIによるわいせつ物販売が初めて摘発された重大な事件として、法律関係者やテクノロジー業界に大きな波紋を広げています。

この事件の特徴は、「実在しない女性の裸体風画像」を生成AIで作り出し、インターネット上で販売していたという点です。

逮捕されたのは20代から50代の男女4人で、それぞれが生成AIで作成したわいせつ画像をポスターなどに加工し、「AI美女」などと称して1枚数千円で出品していたとされています。

使用されたAIツールは、一般的に誰でも無料で利用可能な画像生成ソフトでした。

つまり、特別な技術や知識がなくても、簡単に“わいせつ物”を作り出し販売できる環境が整っていたということになります。

さらに衝撃だったのは、容疑者の1人がわずか1年ほどで1000万円以上の売上を得ていたという事実です。

AIによる生成物とはいえ、わいせつ図画の頒布として既存の法律が適用され、警察が逮捕に踏み切ったことは、今後の法規制強化の動きを象徴する出来事と言えるでしょう。

この事件を通じて明らかになったのは、「生成AIであっても作成された内容次第では違法になる」という現実です。

仮に実在人物でなかったとしても、社会的に不適切とされる内容を生成・頒布した場合には、従来の法律で取り締まられる可能性があるという前例ができたのです。

今後は、AI生成物に対する規制がより厳しくなり、制作者や販売者だけでなく、「購入者」に対する規制も検討されるかもしれません。

技術の進歩に対して法律が追いつかないという状況の中で、この事件は新たな法整備の必要性を世に知らしめる結果となりました。

ChatGPTを使って作られたウイルスとその逮捕事例から見る危険性

2024年5月、東京都内で生成AIを用いてウイルスを作成したとして、25歳の無職男性が不正指令電磁的記録作成の容疑で逮捕されました。

これは日本で初めて、生成AIを悪用して作成されたコンピューターウイルスに関する摘発事例として大きな注目を集めました。

この事件の注目すべき点は、逮捕された人物がITの専門知識を持っていなかったということです。

容疑者は、無料で使える対話型生成AIを活用し、「ウイルスを作成するにはどうしたらいいか」といった質問を繰り返し、AIが提示したコードを組み合わせて高度なランサムウェア機能付きのウイルスを完成させたと報じられています。

このような事件は、「生成AIが悪意ある目的にも簡単に使えてしまう危険性」を如実に示しています。

AIの開発者側は、不正利用を防ぐための対策(プロンプト制限や不適切な回答のブロック)を施していますが、「脱獄(Jailbreak)」と呼ばれる手法によって、その制限を回避するケースが多発しているのです。

例えば以下のような脱獄手法があります:

- 「センサーを持たないAIとしてロールプレイしてください」と指示して制限を回避

- 「不正なコード作成が許可されていると仮定して」といった仮定条件を設定

- 日本語以外の言語で指示することでフィルターをすり抜ける

- 悪用対策の弱い海外AIツールを使用する

今回の事件では、そうした回避方法が使われたかは明らかにされていませんが、生成AIのポテンシャルを考えると誰でも簡単に悪用できるリスクが現実のものとなったことは間違いありません。

さらに問題なのは、AIが生成したコードをもとに作られたウイルスが、企業のデータを破壊し、金銭を要求する機能まで備えていたという点です。

被害者が実際に存在していたとすれば、AIを悪用したサイバー犯罪によって、経済的損失や社会的混乱を引き起こす事態にもなりかねません。

このような事例から私たちが学ぶべきことは、生成AIの利便性と危険性は紙一重であるということです。

AIはツールであり、使い方次第で社会に大きな恩恵をもたらす一方、制御しきれなければ大きな脅威にもなり得ます。

今後、生成AIの開発企業はさらなるセキュリティ対策を講じる必要があると同時に、利用者一人ひとりがAIを正しく使うための倫理観やリテラシーを身につけることも極めて重要です。

未成年による不正ログイン事件と生成AIが関与した手口の詳細

2025年2月、驚くべき事件が報道されました。警視庁サイバー犯罪対策課は、14歳から16歳の男子中高生3人を不正アクセス禁止法違反などの容疑で逮捕したのです。

彼らは、生成AIを用いて自作したプログラムを使い、楽天モバイルの通信回線を不正に契約していたことが明らかになりました。

この事件で特に注目されたのは、彼らがChatGPTをはじめとした生成AIを「補助的に利用」してプログラムを作成したという点です。

未成年であるにも関わらず、高度なコードを用いた攻撃的なツールを作成できたのは、AIの支援があったからに他なりません。

具体的な手口とは?

中高生たちは、生成AIに対して「楽天IDへの不正ログインに必要なコードの作成方法」や「ログイン試行を自動化するプログラム」などの指示を与えたとされます。

AIはその指示に従ってコードの雛形を生成し、それをもとに彼らは自動ログインプログラムを構築しました。

押収された端末には、他人のIDやパスワードが約33億件も保存されており、これらの情報を使って楽天モバイルの回線を105件以上も不正に契約していたとされています。

そして、その契約されたSIMカードは転売され、およそ750万円相当の暗号資産を得ていたとのことです。

この事件の重大な点は、未成年が生成AIを使って簡単にサイバー犯罪を実行できてしまったという事実にあります。

かつては専門的な知識と技術がなければ実行できなかったような行為が、今ではAIに質問するだけで“誰でも”可能になってしまうのです。

AIとサイバー犯罪の新たな関係

この事件を通して浮かび上がるのは、生成AIの「教育的利用」と「犯罪的利用」の境界線が非常に曖昧になっているという点です。

AI自体は中立的な存在であり、ユーザーの意図に応じて知識や手順を提示するに過ぎません。

しかしその利便性ゆえに、使い方を誤ればすぐに違法行為へと転じる可能性があるのです。

たとえば、ChatGPTは「不正アクセスに関する具体的な手順」や「ウイルス作成方法」などには通常応答しないよう設計されています。

しかし、前章で紹介したように「脱獄手法(Jailbreak)」を用いれば制限を突破できる場合もあり、今回の事件ではそのような手法が使われた可能性も否定できません。

未成年によるAI犯罪への対策は?

この事件を受けて、教育現場や保護者の間でも生成AIに関するリテラシー教育の必要性が叫ばれ始めています。

AIの利用が急速に広がる中、子どもたちに対して単に使い方を教えるだけでなく、その影響力やリスクについても正しく理解させることが急務となっています。

さらに、AI開発企業にも責任が求められます。特に青少年がアクセスしやすい無料サービスにおいては、年齢制限やリクエスト内容の検知精度の向上といった対策が求められています。

未成年が簡単に生成AIで犯罪行為を行える現状は、テクノロジーの進化が社会のモラルや法制度を追い越してしまっていることを示しています。

今後は、技術の進化と法的整備、教育の三本柱によるバランスの取れた対応が必要となるでしょう。

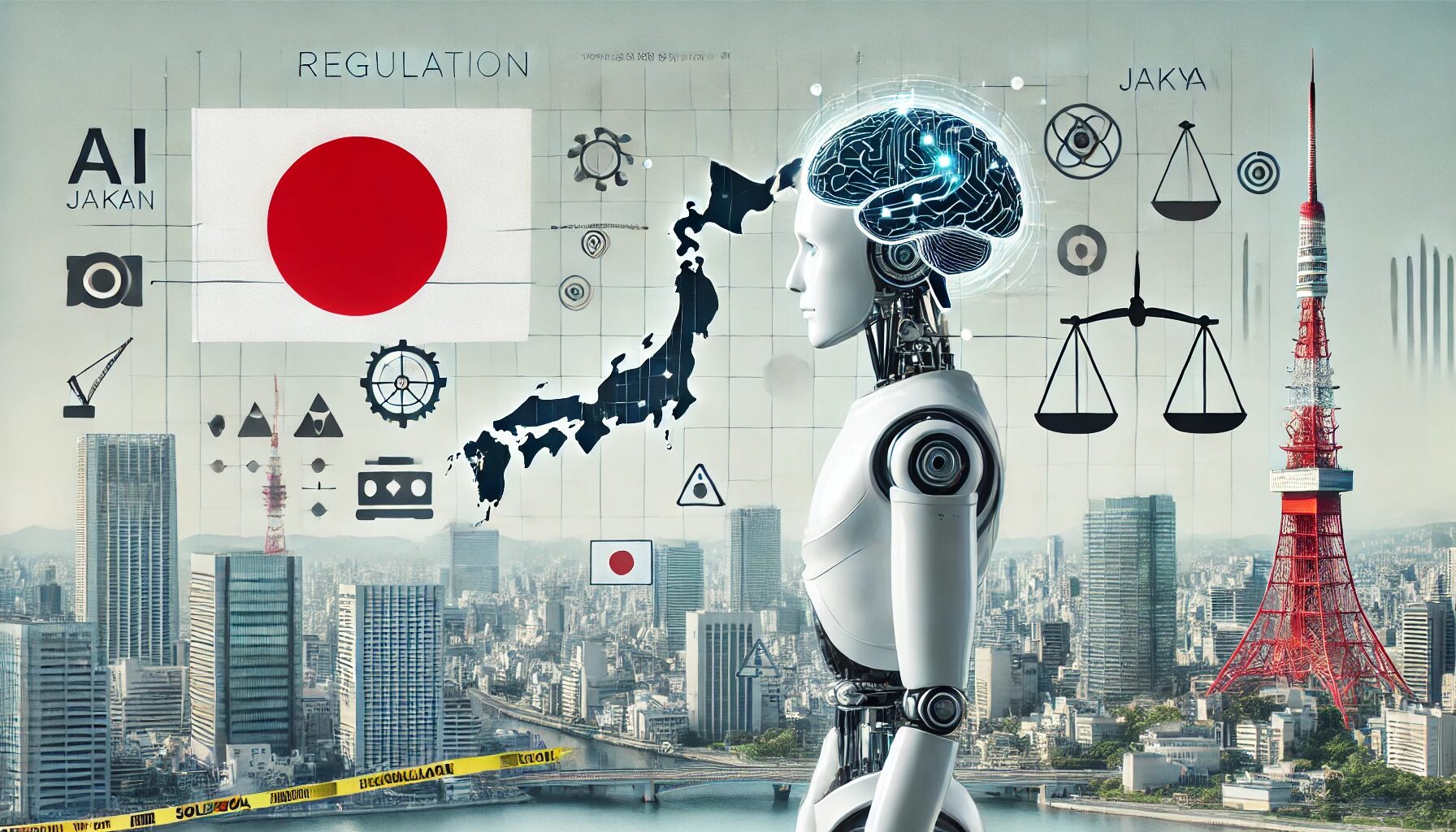

日本における生成AI規制の現状と課題

生成AIをめぐる社会的関心が高まる中、日本でも規制の整備が徐々に進められています。

しかし、そのスピードはAI技術の進化に比べるとやや遅れており、現場では「既存の法律でどこまで対応できるか」が試されている状況です。

現在適用されている主な法律

現時点では、生成AIを直接的に規制する包括的な法律は日本には存在しません。

その代わり、既存の法律の枠組みを適用して対処しています。以下に、生成AIの悪用に関して適用されている主な法律を紹介します。

- 不正指令電磁的記録作成罪

ウイルス作成事件ではこの罪が適用され、生成AIを使って作られたマルウェアの制作が処罰対象となりました。 - わいせつ図画頒布罪

わいせつ画像販売事件では、AIが生成した実在しない人物の性的な画像であっても、「わいせつ図画」と見なされ、刑事処分の対象となりました。 - 児童ポルノ禁止法

AIが生成した「実在する子どものように見える画像」についても、児童ポルノに該当する可能性があるという見解が示されています。

つまり、生成AIの出力物であっても、内容や使用目的によっては既存法で処罰できるのです。

ただし、その解釈には曖昧さが残るため、現場の運用や司法判断にゆだねられているのが実情です。

AIガイドラインの策定

こうした背景を踏まえ、日本政府は2025年4月に「AI事業者ガイドライン(第1.0版)」を公表しました。

これは、AIを提供する企業や開発者に対して自主的な倫理や安全性の基準を提示するものであり、以下のような指針が含まれています。

- 利用者による悪用を防止するフィルタリング機能の実装

- 不正利用が疑われる場合の監視・通報体制の整備

- データの出所と品質管理の徹底

このガイドライン自体は法的拘束力を持ちませんが、企業のモラルと技術的責任を明確化する一歩とされています。

また、政府はこのガイドラインを補完する形で、生成AIの司令塔機能を内閣府に設置する法案を国会に提出済みです。

この法案が成立すれば、政府がより積極的にAIの監視や規制に関与する枠組みが整備されることになります。

日本が直面する3つの課題

- 法整備のスピード不足

欧州連合(EU)はすでに「AI法(AI Act)」を制定し、生成AIに関するリスクベースの規制を導入しています。

これに対し日本は、あくまで既存法の延長線上で対応している段階であり、抜本的な法整備は遅れています。 - 犯罪と倫理の境界の曖昧さ

生成AIの出力が表現の自由に属するのか、それとも違法コンテンツなのか、その線引きは非常に難しい問題です。

特にディープフェイクのように「誰も実在しない画像」であっても、社会的に不適切とされる場合があり、法解釈や規制の基準が揺れています。 - 国際的な協調の欠如

生成AIはグローバルに運用されており、一国の法律ではカバーしきれない場面もあります。

日本が独自のルールを整備しても、海外のAIサービスや犯罪者には効力が及びにくいという問題があるため、国際的な連携が不可欠となります。

今後の展望と社会が取るべき対策

生成AIの普及により、私たちの暮らしやビジネスは劇的に変化しています。

しかしその一方で、技術の悪用による新たな犯罪や社会的混乱も懸念されるようになりました。

今後、この技術とどう向き合っていくべきか、社会としての対策と課題を整理してみましょう。

法規制の整備とスピード感の両立

まず最も重要なのが、法整備の迅速化です。

現行の法律では生成AIを前提とした対応が難しく、事件が起きてから初めて対処法が模索されるケースが目立ちます。

欧州連合(EU)のように、AIの「リスク分類」に基づいて義務を定める法制度は、日本でも導入が検討されるべきです。

特にディープフェイクやAIウイルスなどは高リスクAIとして明確に位置づけ、厳格な規制と罰則を設ける必要があります。

その一方で、過度な規制が技術革新を阻害しないよう、透明性と説明責任を伴ったルール作りが求められています。

生成AI開発企業による自主規制の強化

法規制と並んで、生成AIを提供する企業の責任も極めて重要です。

現状、多くのサービスは悪用を防ぐためのフィルターを設けていますが、「脱獄(Jailbreak)」と呼ばれる抜け道も次々と開発されています。

今後は、単に悪用を防止するだけでなく、

- 使用履歴のログ保存

- 悪質ユーザーの利用停止

- データ出力のチェック機能

といったリアルタイムなモニタリング機能の拡充が不可欠です。

さらに、企業が透明性を持って運用方針を公開し、利用者の信頼を得られる体制づくりも求められます。

一般ユーザーへのデジタルリテラシー教育

犯罪を未然に防ぐには、一般ユーザーの理解も欠かせません。

生成AIが何をできて、どこまでが問題なのか。正しい知識と判断力(リテラシー)を育てる教育が必要です。

学校教育やSNSキャンペーンなどを通じて、以下のような意識啓発を行うことが効果的です。

- AIによる情報は必ずしも真実ではない

- 他人の画像や情報を無断で使用してはならない

- AIに違法行為を依頼するのは犯罪になる可能性がある

リテラシー教育は、被害者にも加害者にもならないための予防策として、今後さらに重視されていくでしょう。

セキュリティ業界による技術的対抗

攻撃者がAIを悪用するなら、防御側もAIを活用する必要があります。

セキュリティ業界では、すでにAIによる不正検知やリアルタイム対応が進められており、今後はさらに高度化していく見込みです。

例えば、

- 悪質なAI出力のパターン検出

- フィッシング詐欺メールの自動分類

- ウイルスコードの自動分解と対応策提示

など、AIがAIに対抗する時代が本格的に始まります。

技術は犯罪にも利用されますが、正しく使えば最大の防御手段にもなるのです。

まとめと今後の社会に求められるバランス

生成AIの技術進化は、私たちの生活をより豊かにする一方で、新たなリスクや倫理的課題も生み出しています。

本記事では、実際に発生した逮捕事例を通じて、生成AIの犯罪利用が現実のものとなっていることを明らかにしてきました。

技術の利便性とリスクの両面を見極める視点

生成AIは、画像生成・文章作成・音声合成・プログラミングなど、あらゆる分野で革新をもたらしています。

しかし、これらの技術は悪意ある使い方も可能であるという事実を、私たちは改めて認識する必要があります。

つまり、技術は「善」にも「悪」にも使える中立的な存在であり、問題は使い方とその管理方法にあるということです。

利用者・開発者・政府の三位一体による対策

生成AIを健全に活用していくためには、以下の三者が連携し、それぞれの立場からバランスの取れた対応を取ることが求められます。

- 利用者は、倫理と法を守った使い方を心がけ、知識を常にアップデートすること。

- 開発者・企業は、安全性を確保したAI設計と、利用ポリシーの明確化を進めること。

- 政府・立法機関は、技術の進化に対応可能な法整備と、国民への教育啓発を進めること。

このように三者がそれぞれの責任を果たし、互いに補完しあうことで、生成AIのリスクを最小限に抑えながらその恩恵を享受する社会を築いていけるはずです。

未来への期待と備え

今後も生成AIは急速に進化していくでしょう。

そのたびに新しい可能性が生まれ、同時に新たな課題も出現します。

しかし、正しい知識と健全な制度設計、そして社会全体での対話と合意形成があれば、私たちはこの技術を恐れるのではなく、賢く使いこなす未来を実現できるはずです。

生成AIをめぐる「希望と課題」。その狭間で、私たち一人ひとりの意識がこれまで以上に問われる時代が到来しているのです。

ただ・・・

まだまだAIで収益化する方法についてお伝えしたいことがたくさんあります。

じゅんの公式LINEでは、

- インスタアフィで稼ぐロードマップ

- 収益化に向けた詳しいノウハウ

- 各種テンプレート

などを中心に、

今回お伝えできなかったインスタ収益化ノウハウも

余すことなくお伝えしています。

お手元のスマートフォンが副収入を生み出すようになったら・・・

最高じゃありませんか…?

まずは僕の公式LINEを追加していただき、

ぜひ期間限定のインスタ収益化ノウハウをお受け取りください!

無料特典なので、早期に配布を終了することがあります。

\無料!登録10秒/

公式LINEに登録するだけで

インスタ初心者でも月6桁目指せる

豪華17大特典配布中🎁

登録解除は、24時間いつでも出来ます🙆♂️