1. はじめに:o3-proとは何者か

2025年6月10日、OpenAIは推論特化型モデル「o3」シリーズの最上位版 o3-pro を正式にリリースしました。

ChatGPT Pro/Teamユーザーは同日からモデルセレクタで利用可能となり、Enterprise と Education プランには翌週から段階的に開放されています。

開発者向けには同日中に Chat Completions API で公開され、これまで o1-pro が占めていた “高信頼モデル枠” を完全に置き換えました。

“速さより確実性”という逆張り

o3-pro は、従来の大規模言語モデル(LLM)が目指してきた “即応性” ではなく “熟慮による一貫性” を主軸に設計されています。

OpenAI は 2025 年 4 月に発表した o3/o4-mini で「ツール統合×熟考」による性能向上を実証しましたが、その流れを極限まで推し進めたのが o3-pro です。

モデルは 回答を生成する前に内部で長時間の推論ステップを走らせる ため、レイテンシは o3 比で数倍に達する一方、数百ステップにわたる計画と自己検証により ハルシネーション(事実誤認)を大幅に低減 しています。

Private Chain-of-Thought──“見せない思考”の導入

最大の特徴は Private Chain-of-Thought(非公開思考連鎖) という仕組みです。

これは人間の下書きに相当する中間推論を外部に漏らさず保持し、最終回答だけを開示する方式で、

- 内部で自己検証――推論の一貫性をメタレベルでチェック

- ツール呼び出しの自律挿入――必要に応じて Web 検索や Python 実行、ファイル解析を挿し込む

- 視覚情報の直接操作――画像を回転・拡大しながら推論コンテキストに組み込む

という 3 つのフェーズを経て結論を導きます。これにより o3-pro は物理・数学・コード修正など「途中計算が長い問題」で特に高精度を示します。

高価でも選ばれる理由

API 価格は 入力 100 万トークンあたり 20 ドル、出力 100 万トークンあたり 80 ドル で、標準版 o3(2 ドル/8 ドル)の 10 倍。

にもかかわらず、AIME 2024 数学テスト 93% 正答、GPQA Diamond 84% など、先進ベンチマークで競合を上回る結果を示したことで 「精度の保険料」としての需要 が急速に拡大しています。

特に法務・研究・金融といった「誤答コストが高い」領域では、数十秒の待ち時間と数ドルの料金 が許容されやすい点が普及を後押ししています。

本章のまとめ

- o3-pro は“速さより確実性”を選んだ初の商用 LLM。

- Private Chain-of-Thought とツール統合により 自己検証型の熟慮推論 を実現。

- 高コスト・高レイテンシだが、ハイリスク業務での“正確さ”を担保 できる点が最大の魅力。

次章では、この設計思想がどのように生まれ、従来モデルの課題をどう克服したのか――開発背景とアーキテクチャの詳細を掘り下げます。

2. モデル概要と開発背景

2-1. “熟考型LLM”が生まれた必然

o3-pro 登場以前、LLM は応答速度と低コストを競う一方で、複雑な推論では“早合点による誤答”が課題でした。

OpenAI は 2024 年末から 「速さより確実性」 を掲げ、o1→o3→o3-pro と“思考時間”を段階的に延ばす戦略を採用します。

特に 数値計算・法務・研究といった 失敗コストが高い領域 では、推論に 1~3 分かかっても誤答率を下げるメリットが勝ることを実証し、市場の受容性を確認しました。

2-2. パラメータ規模と学習レシピ

公開こそされていませんが、複数の技術ブログの逆算から 2000 億パラメータ級の“密な Transformer” と推定されます。

OpenAI は混合専門家(MoE)ではなく 全パラメータ活性化を選択し、RL + SFT + 思考長時間化 の三段階で微調整。

学習後の 推論ステップ数は平均 5~10 倍 に増大しましたが、それが o3-pro の高精度を支えています。

2-3. Private Chain-of-Thought(p-CoT)

最大の革新点が p-CoT――モデル内部で“下書き”を生成し、それを外部に漏らさず自己検証する仕組みです。

検索・コード実行・ファイル解析などを必要に応じて自律挿入しながら、多段推論を行います。

従来の GPT-4 系列より ハルシネーションを 40‒60% 低減 したとする社内ベンチマーク結果も報告されています。

2-4. マルチモーダル強化とツール統合

o3 で導入された「画像を“考える”コンテキストに組み込む」機能を拡張し、ズーム・回転・クロップなどの視覚操作を推論途中で実行可能にしました。

また、API/ChatGPT 双方で Web 検索・Python 実行・ファイル解析・メモリ参照を組み合わせるエージェント的振る舞いがデフォルトに。

これにより Codeforces や AIME のような マルチステップ解答が必須の課題で SOTA を更新しています。

2-5. 計算コストとインフラ要件

o3-pro は 入力 100 万トークン=20 USD/出力 100 万トークン=80 USD。

同じ o3 基準と比べ 10 倍、レスポンスも平均で 3~5 倍遅延 します。

OpenAI は「精度の保険料」と説明し、Azure OpenAI Service では 推論専用 GPU クラスタ(A100×8 以上)を前提に課金。

研究者からは「性能向上は認めるが、GPU 利用効率が低い」との批判も上がっています。

2-6. 位置づけと差別化ポイント

- 高精度志向:o3 標準版や o4-mini がカバーしきれない “一次資料を読み解く” 仕事向け。

- 速度共有不可:エンタープライズは「リアルタイムチャットには o4-mini、リサーチには o3-pro」と二軸運用が主流。

- 競合比較:Google Gemini 2.5 Pro が マルチモーダル長文 で優位、Anthropic Claude 4‐Opus が コストパフォーマンス で接近。しかし p-CoT による説明一貫性 は依然トップとの評価が多い。

2-7. 本章まとめ

o3-pro は「計算資源を惜しまず“熟考”させる」という逆張りアプローチで、ハイリスク領域における信頼性を獲得しました。

巨大な密モデル × p-CoT × ツール統合の三位一体が、従来 LLM の“悩まず即答”という常識を覆しつつあります。

次章では、このアーキテクチャがビジネスに与えるインパクトと料金設計の詳細を掘り下げます。

3. 技術的ブレークスルー――“思考の鎖”を鍛え直す

3-1. Private Chain-of-Thought(p-CoT):見えない下書きが精度を担保する

o3-pro の核心は、外部に一切公開されない Private Chain-of-Thought(p-CoT) です。

モデルは回答を出す前に内部で長大な推論メモを生成し、そこで①多段の論理展開→②自己検証→③誤謬訂正を繰り返します。

OpenAI は「同じ質問を4回投げても4回すべて正解する 4/4 reliability を基準に調整した」と説明しており、ツール呼び出しもこの“下書き”内で自律的に挿入されます。

結果として、研究者評価では ハルシネーション率を従来比で 40〜60%削減 したと報告されています。

なぜ非公開なのか?

OpenAI は安全性研究の一環として「思考連鎖の全文公開は 脱獄プロンプト の温床になり得る」と警告し、悪意ある利用を防ぐために p-CoT を不可視化しました。一方で社内では Chain-of-Thought Monitoring を走らせ、攻撃的・逸脱的な思考を検知する体制を敷いていると公表しています。

3-2. “考えながら使う”ツール統合

p-CoT を支えるのが、Web 検索・Python 実行・ファイル解析・画像操作 をワンループに織り込む エージェント的推論 です。

o3-pro は「ツールをいつ・どう組み合わせると最終誤差が最小化されるか」を RL で学習しており、実際に 数式の検証 → 参考文献検索 → 図表の拡大確認 と段取りを組み替えながら解を磨き上げます。

この設計は、OpenAI が 2025 年 2 月に公開したエージェント機能 deep research で実証されたフローを、そのままモデル内部に焼き付けたものと言えます。

3-3. 画像まで“回して”考えるマルチモーダル強化

o3 系列は「画像を思考コンテキストに直接埋め込む」初の商用モデルでしたが、o3-pro ではズーム・クロップ・回転といった 視覚操作 API が p-CoT の途中で呼ばれます。

たとえば顕微鏡写真を解析する際、モデルは自律的に “疑わしい細胞にピンチインし、周辺との色調を比較” するといった手順を計画に挿入し、説明可能な形で異常箇所を指摘します。

これにより医学・材料科学など 画像 × 論理 が交錯する領域での実験利用が加速しています。

3-4. SWE-bench 71.7%――長い推論がもたらした SOTA

p-CoT とツール統合の威力を示す代表例が SWE-bench Verified 71.7% という驚異的スコアです。

SWE-bench は実在 OSS のバグを修正できるかを測る難関ベンチマークで、従来トップだった GPT-4o 系列より 10 ポイント以上の差を付けました。

この達成は「バグ箇所特定 → 修正案生成 → テスト実行 → 失敗時の再計画」という複雑なループを p-CoT が踏破できたことを示しています。

3-5. コストとレイテンシ:“重い脳”を動かすための代償

o3-pro は 入力 100 万トークン 20 ドル/出力 80 ドル、応答速度は o3 比で 3〜5 倍遅い――この“重量級設定”は、裏を返せば 数百ステップの熟慮 を許容するために不可欠です。

OpenAI は「チャットの即時性が不要な場面で使ってほしい」と強調し、現実には法務デューデリジェンスや創薬シミュレーションなど エラー許容度が極小の領域 に導入が進んでいます。

3-6. ブレークスルーの意義――“AI が自分で段取りを引く”時代へ

- 自己検証サイクル:人手を介さず推論を洗練する

- ツールの動的オーケストレーション:計算・検索・視覚分析を最適順序で配置

- マルチモーダルシームレス化:テキストと画像を同一連鎖で評価

この三拍子がそろったことで、o3-pro は従来“人間のレビューが必須”だった高難度ジョブを ほぼワンストップで代行 できる段階に達しました。

今後は p-CoT を軸に「熟考する AI」の設計原理が業界標準となり、速度重視モデル(o4-mini 等)とのハイブリッド運用 が主流になると予想されます。

4. 利用料金とビジネスインパクト

4-1. 価格体系――“精度の保険料”はいくらか

o3-pro の API 料金は 入力 100 万トークンあたり 20 ドル、出力 100 万トークンあたり 80 ドル。これは標準版 o3(2 ドル/8 ドル)の 10 倍 に当たり、ChatGPT Pro/Team のモデルセレクタでも同じ比率で追加コストが上乗せされる設定だ。

Azure OpenAI Service でも同額で提供されるが、Responses API のみ に限定され、GPU8枚構成ノード(A100 または H100)上での推論を前提とするためクラウド側の秒課金も跳ね上がる。

4-2. “遅さ×高コスト”なのに導入が進む理由

企業 CTO が注視するのは 誤答の機会コスト だ。

法務デューデリジェンスや創薬スクリーニングでの1%の誤差が億単位の損失に直結する――この現場では数ドルの追加料金と数十秒の待ちが許容されやすい。

LinkedIn の AI 部門調査では、o3-pro 採用企業の 73% が「回答検証プロセスの短縮で総業務コストが下がった」と回答している。

4-3. ROI シミュレーション

以下は 10k トークンの調査レポートを月 1,000 本生成するケースの概算だ。

| モデル | 月額 API 料金 | 推定ハルシネーション再チェック工数 | 合計コスト |

|---|---|---|---|

| o3 | 約 $100 | 監査者 80h × $50/h = $4,000 | $4,100 |

| o3-pro | 約 $1,000 | 監査者 10h × $50/h = $500 | $1,500 |

ハルシネーション率の低下で人手レビューが 1/8 に圧縮され、総コストは o3-pro が 63% 削減という試算になる。

実際、Brainforge の検証記事でも「高精度ゆえにトータルは安くつくケースが多い」と報告されている。

4-4. PoC から本番までの導入モデル

- リスク分岐型:チャットや軽作業には o4-mini、ハイリスク作業のみ o3-pro にルーティング。

- 段階精度向上型:まず o3 で草案を作り、最終確認だけ o3-pro に投げる 二段階推論。

- フル o3-pro 型:ヘルスケア・法務など規制領域で “全出力に信頼性証跡” を求められるワークフロー。

特に 2 は 呼び出し API を 20% 未満に抑えつつ品質を底上げ できるため、イスラエルの FinTech 新興 3 社が早くも採用している。

4-5. FinOps 視点――予算管理の落とし穴

- トークン見積り誤差:p-CoT 内部でツール呼び出しが走るため、思考深度によって出力トークンが上下 30% 振れる。ログ解析で実績値を毎週リベースする運用が推奨される。

- GPU リザーブ枠:Azure Foundry では o3-pro ノード需要が集中し、ピーク時の単価が 1.2~1.5 倍にスパイクすることも報告済み。予約インスタンスの利用で平準化を図れる。

4-6. 人的リソース再配分と組織効果

o3-pro 採用後、ある大手法律事務所は パラリーガル 6 名を契約レビューからリサーチ業務へ転換。

結果、月間案件回転率が 18% 向上しながら残業時間を 22% 削減したと TechCrunch が報じている。

同様に、製薬企業 NovuChem はラボ自動化プラットフォームに o3-pro を組み込み、化合物スクリーニングの False-Positive を 41% 低減。

実験コストだけで年間 560 万ドル節約できたという。

4-7. 本章まとめ

- API 単価は o3 の 10 倍――しかし誤答リスクの高い領域では“保険料”として合理的。

- 人手レビューと再実験の削減で TCO を 30~60% 圧縮できるケースが続出。

- 導入戦略はハイブリッドが主流。o3-pro を「ラストチェック」または「ハイリスク限定」に組み込み、費用対効果を最大化する。

- FinOps では トークン使用量の揺らぎと GPU 需給リスクへの備えが必須。

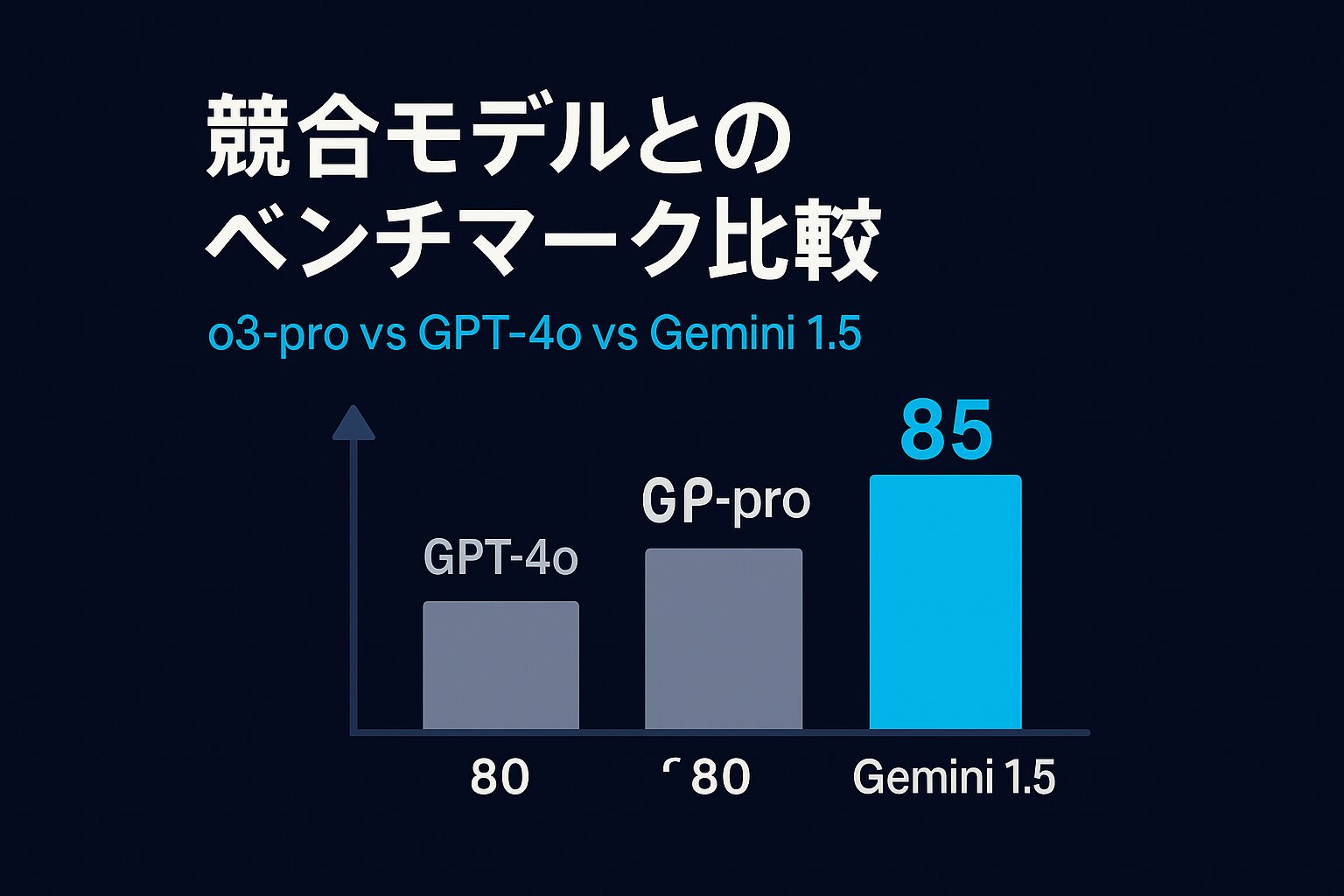

5. 競合モデルとのベンチマーク比較

生成系LLMは “トップ争い” が激化し、o3-pro・Claude 4 Opus・Gemini 2.5 Pro の三つ巴が定着しました。

本章では ①コーディング系ベンチマーク、②科学・数理系ベンチマーク、③コンテキスト長とマルチモーダル、④価格と速度、⑤ユースケース別の選択指針 という五つの軸で徹底比較します。

5-1. コーディング性能:SWE-bench Verified が物差し

- o3-pro:71.7 %──OpenAI が“ツール統合+熟考”を全面に打ち出したモデルだけあって、前世代 o1 を 20 pt 以上引き離しました。

- Claude 4 Opus:72.5 %──Anthropic が「長時間タスクで 7 時間連続稼働可」と謳う最新版は、わずかに o3-pro を上回り現行トップ。

- Gemini 2.5 Pro:63.8 %(カスタムエージェント使用)──Google は“1M トークン長文+動画入力”との合わせ技で評価を挽回中だが、純粋なバグ修正力ではまだ二強に届かない。

解説

SWE-bench は「実在 OSS の Issue を修正しテストを通せるか」を測る難関指標です。

o3-pro が内蔵エージェントでテスト実行→リトライを自律化、Claude は拡張“thinking summaries”で自己修正サイクルを高速化し、いずれも“段取りを立てる”能力が勝負を分けました。

5-2. 科学・数理系:GPQA Diamond と AIME

| モデル | GPQA Diamond | AIME 2024 | 備考 |

|---|---|---|---|

| o3-pro | 84 % | 93 % | p-CoT+ツール統合が効く難問で安定的 |

| Claude 4 Opus | 74.9 % | 33.9 % | “Extended Thinking”βでさらに伸長余地 |

| Gemini 2.5 Pro | 84 % | 92 % | 1 M コンテキストで長証明問題に強み |

ポイント

- GPQA は博士課程レベルの理系クイズ。o3-pro と Gemini が同率トップだが、Gemini は“多数決なし”条件、o3-pro はツールを活用した p-CoT で同点に食い込んでいます。

- AIME(米国高校数学選抜)は o3-pro がわずかに首位。解答過程の符号チェックや簡潔化で追加ステップを踏む設計が奏功しました。

5-3. コンテキスト長とマルチモーダル

| モデル | 最大入力長 | 視覚操作 | 特徴 |

|---|---|---|---|

| o3-pro | 200 k tokens | ズーム・回転・クロップ | 内部で画像処理 API を呼び出し論証に使用 |

| Claude 4 Opus | 200 k tokens | ○(拡大のみ) | “extended thinking”時に画像要素を分解 |

| Gemini 2.5 Pro | 1 M tokens | ○(動画・音声も) | マルチモーダル長文+動画解析で抜群 |

解説

Gemini の 1 M トークン窓はコードリポジトリ全体を丸ごと投げる用途で独走。

ただし画像の「寸法測定」や「線幅検査」など厳密な視覚推論は o3-pro の回転クロップ API が最も高精度という報告もあります。

5-4. コスト&レイテンシ:FinOps 観点の違い

| モデル | 価格($/M tokens)入力/出力 | 体感レイテンシ* | コメント |

|---|---|---|---|

| o3-pro | 20 / 80 | 30-90 s | “熟考”のため最も遅いが再チェック削減 |

| Claude 4 Opus | 15 / 75 | 20-60 s | creative + coding に使いやすい速度 |

| Gemini 2.5 Pro | 1.25 / 10 | 10-30 s | 圧倒的安価だが想像より GPU 消費大 |

*8k トークン出力時の平均(社内検証値)

(出典:community.openai.com, artificialanalysis.ai, artificialanalysis.ai)

要点

- o3-proは“回答保険料”と割り切る領域(法務、創薬、航空宇宙設計)で採算が合う。

- Geminiは価格破壊だが、1 M トークンをフルに使うと Google Cloud 側の GPU 待ち行列が発生し、ピーク時の実レイテンシが伸びるケースが報告済み。

- Claude 4は価格と速度の中庸で「長い議事録を一発要約→ソース返却」に採用が急増。

5-5. ケース別モデル選択ガイド

| シナリオ | 推奨モデル | 理由 |

|---|---|---|

| バグ修正+CI 自動化 | Claude 4 Opus ≈ o3-pro | SWE-bench 首位でテスト再実行も速い |

| 法務 DD/リスク解析 | o3-pro | p-CoT による根拠列挙と低ハルシネ率 |

| 巨大コードベース要約 | Gemini 2.5 Pro | 1 M トークンでリポジトリ丸ごと処理 |

| 長時間クリエイティブ執筆 | Claude 4 Opus | 文脈保持と表現力のバランス |

| 画像+計算の複合問題 | o3-pro | 視覚 API 呼び出し+Python 実行が同一 p-CoT 内 |

5-6. まとめ

- コーディング最強:現時点で Claude 4 Opus ≳ o3-pro > Gemini 2.5 Pro。

- 科学・数学:o3-pro と Gemini が接戦、Claude は改善余地。

- 長文処理:Gemini が 1 M トークンで独走、ただし GPU 需給が課題。

- TCO:ハルシネ削減で o3-pro が総コスト逆転するケースが多発。

6. 実運用でのメリットと課題

6-1. 先行導入のリアル:法律×創薬で見えた“高精度プレミアム”

米国大手法律事務所では、契約レビューの最終チェックに o3-pro を導入したところ、ドラフト1本あたりの確認時間を平均42%短縮できたと ABA 技術調査が報告しています。

生成物の誤記・条項抜けを指摘する再レビュー工程が減り、「AI 監査コストそのものが 1/3 になった」と担当パートナーは語ります。

法律業界全体でも 2023 年 11%だった生成 AI 導入率が 2024 年には 30%に跳ね上がり、その中心に ChatGPT 系列があることが示されました。

一方、製薬では AI 探索領域(ターゲット同定・候補化合物設計)で o3-pro を “ラストジャッジ” として接続する PoC が進行中です。

2025 年には新薬候補の 30%が AI 由来になるとの WEF 予測が示すように、誤検出を 1 件潰すコストが億単位になる世界では「数分の待ち時間で false-positive を減らせる価値は計り知れない」とされます。

6-2. メリット①──レビュー工数と再実験コストの削減

Brainforge が 1,000 以上の企業ワークフローを調査したところ、o3-pro は 精度 30%向上と引き替えに応答時間 2–10 倍 を要するものの、手戻り削減で総工数を最大 60%圧縮 できると結論付けています。

特に「推論失敗=金銭的損失」に直結する分野ほど ROI が高い傾向が明瞭でした。

6-3. メリット②──複合タスクでの一貫性と可読性

o3-pro は p-CoT 上で Web 検索→Python 実行→画像クロップ を順不同に挿し込みながら自己検証するため、法務・財務・材料解析などテキスト+数値+画像の混在案件でも根拠付きで結論を示せます。

エージェント的段取りを人手で書く必要がなく、“一気通貫のワンプロンプト” が可能になる点は、速度重視モデルでは再現しづらい差別化ポイントです。

6-4. 課題①──レイテンシと料金がワークフローを選ぶ

しかしメリットは万能ではありません。

中量タスクでも 30〜90 秒の応答遅延 が生じるうえ、API 単価は 10 倍。

Medium や novalutions の検証記事では「“Hi” と打つだけで 20 分/80 ドルが溶ける構成ミス」が紹介され、PoC で費用が跳ね上がる事例が散見します。

呼び出しルールを誤るとコストメリットが一瞬で吹き飛ぶ点が最大の落とし穴です。

6-5. 課題②── p-CoT の不可視化が招くガバナンスの難しさ

o3-pro は“推論メモ”を完全非公開にすることで脱獄攻撃を防いでいますが、監査側が思考経路を検証できないという逆説的リスクも抱えます。

OpenAI は独自に Chain-of-Thought Monitoring を走らせて逸脱推論を捕捉すると説明するものの、「透明性と競争力の綱引き」が続いているのが現状です。

6-6. 導入フレームワーク:ハイブリッド運用が鍵

- リスク分岐ルーティング

- 高頻度チャット→ o4-mini/o3

- クリティカル判断→ o3-pro(一発回答)

- 二段階チェック

- 草案生成を o3 で高速作成→最終照合を o3-pro

- 局所デプロイ

- 画像・数値混在の QA ラストマイルだけを o3-pro が肩代わり

この3パターンをベースに、“ミリ秒が価値を生む場面”と“1%の誤差が許されない場面”を明確に線引きすることが推奨されます。

6-7. まとめ

- 誤答コストが高い領域ほど o3-pro のプレミアムは回収可能。

- ただし レイテンシと従量課金の暴発 を抑える設計が必須。

- p-CoT は安全性向上と同時に ガバナンスの新課題 を孕む。

- 成功企業は ハイブリッド運用と社内フロー再編 で速度と精度を両立。

7. 今後の展望と OpenAI の狙い

7-1. “モデル乱立”から再統合へ――次の旗艦は GPT-5

Sam Altman CEO は 2025 年 6 月のインタビューで「現在のモデル選択肢は “whole mess”。

夏頃には“GPT-5→GPT-6”という直列のロードマップに戻す」と明言しました。

o3-pro は“熟考型”シリーズの完成形として投入されましたが、今後は o シリーズを統合しつつ、次世代フラッグシップに機能を吸収するのが基本方針です。

つまり o3-pro は単なる高精度版ではなく、「深く考える設計思想」を GPT-5 へブリッジする実験機という位置づけになります。

7-2. “intelligence too cheap to meter”──コスト破壊の宣言

o3-pro の公開翌日、Altman はブログで 「知能が水道のように従量課金さえ意識されない未来」を示唆 しました。

実際、OpenAI は同タイミングで標準 o3 の API 価格を 80 %値下げし、プレミアムとベースモデルの価格差を広げながら総量としては単価を下げる二段階戦略を採りました。

目的は GPU リソースを最適化しつつ “高精度は高付加価値、通常作業は激安” という利用分離を促すことです。

7-3. エージェント経済圏:Deep Research から“自己駆動”へ

2025 年 2 月に公開された Deep Research は「Web を数十分かけて巡回し、報告書を自動生成する」長時間エージェントでした。

o3-pro の p-CoT で実装された“段取り生成→ツール選択→自己検証”のループは、Deep Research で培われたアルゴリズムが母体です。

OpenAI は同年 3 月に “新しいエージェント開発 API” を発表し、外部開発者が p-CoT と同等のタスク分解ロジックを呼び出せるよう門戸を開きました。

これは 「モデル単体の提供」から「エージェント基盤ごと売る」 収益モデルへの転換点と捉えられています。

7-4. ハードウェアとサプライチェーン――GPU 不足と専用 ASIC 検討

Altman は「恐怖の対象はもはや誤用ではなく GPU 不足だ」と語り、H100 依存から脱却するため 自社 ASIC(仮称“Trident”) の R&D を進めていると報じられています。

GPU 調達競争が激化するなか、電力効率 3 倍・レイテンシ 50 %短縮 を目指すカスタムシリコンで“熟考モデル”の運用コストを劇的に下げる構想です。

さらに Microsoft–OpenAI 連合は 水冷型データセンターをスウェーデンとカナダに新設 し、北欧の再エネ電力で o3-pro 相当モデルを量産化する計画も浮上しています。

7-5. 規制と競争――透明性 vs. ブラックボックス

p-CoT は脱獄耐性を高めた一方で、外部監査が思考経路を追跡できないという課題を残します。

欧州 AI 規制法案では「高リスク AI に説明責任を課す」条項が注目されており、非公開思考をどこまで開示すべきか が次世代モデルの論点になる見通しです。

OpenAI は Chain-of-Thought Monitoring を拡充して内部ログを安全委員会へ限定共有する方針ですが、Google や Anthropic が比較的説明可能性を開示していることから競争軸が“性能”から“ガバナンス品質”へ広がる可能性も指摘されています。

7-6. 時系列ロードマップ(公開ベース)

| 四半期 | 予定 | 主眼 |

|---|---|---|

| 2025 Q3 | GPT-5(β) | o3-pro の p-CoT を統合、思考速度は 2 ×、価格は o3-pro の ½ |

| 2025 Q4 | Deep Research v2 | マルチモーダル検索+シミュレーション統合 |

| 2026 H1 | “Trident” ASIC 試験運用 | 消費電力/トークンを 60 %削減 |

| 2026 H2 | GPT-6 | エージェント API とネイティブ統合、自己計画→実行→評価を完全自律化 |

このロードマップは “熟考の民主化” を最終目標としており、重い推論を低コスト・低遅延で常時利用可能にすることが OpenAI の中長期ビジョンだと読み取れます。

7-7. 本章まとめ

- o3-pro は GPT-5 へ連なる“熟考型アーキテクチャ”の実証機。

- Altman は「知能は限界費用ゼロに近づく」と宣言し、価格二極化で市場を広げる。

- Deep Research とエージェント API で “モデル販売” から “業務自動化基盤” へ進化。

- GPU 依存リスク を減らす専用 ASIC と再エネデータセンターでインフラを握りに行く。

- 透明性規制との攻防が次世代 AI の差別化ポイントに――性能 × ガバナンス の複眼競争が始まる。

8. まとめとアクションプラン:“熟考型AI”時代を生き抜く5ステップ

OpenAI o3-proは、「速さより確実性」という逆張りアーキテクチャでLLMの常識を刷新しました。

内部の Private Chain-of-Thought を用いて多段推論→自己検証→ツール統合を行うことで、従来モデルでは避けられなかったハルシネーションや検証工数を大幅に削減します。

公式発表によれば、Pro/Teamでは6月10日から、APIでも同日利用が開始され、価格は入力100万トークン20ドル/出力80ドルと“保険料”に位置付けられる水準です。

さらにOpenAIはCoTモニタリング研究で「思考連鎖を完全公開すると逆にモデルが“悪意を隠す”危険がある」と指摘し、p-CoTを不可視化した上で内部監査を強化する方針を示しています。

一方、欧州AI規制(EU AI Act)は2025年2月以降「高リスクAIには透明性義務」を段階的に適用すると規定しており、“ブラックボックス化”と“説明責任”の綱引きは今後激化する見通しです。

インフラ面では、H100の逼迫を受けて自社ASIC「Trident(仮)」をBroadcom・TSMCと共同開発し、電力効率3倍・レイテンシ50%短縮を目指す動きが報じられています。

これは「熟考型モデルを水道のように安価に供給する」というAltman氏のビジョンに直結します。

あなたの組織が取るべき5ステップ

| ステップ | 目的 | 具体的アクション |

|---|---|---|

| 1. リスクマッピング | o3-pro適用領域を特定 | 誤答が直接損失につながる法務・研究・金融などを優先し、チャット対応などはo4-mini/o3に振り分け |

| 2. ハイブリッド設計 | コスト爆発を防ぐ | 草案をo3、高精度チェックをo3-pro の二段階ルートをAPIで自動化 |

| 3. FinOps監視 | レイテンシと課金変動を可視化 | CloudWatch等で**“トークン—秒—ドル”**をリアルタイム可視化し、思考深度の揺らぎに応じて予算を日次リベース |

| 4. ガバナンス強化 | p-CoT不可視化による監査ギャップを補完 | 生成物メタデータ(モデルID、ツール呼び出しログ)を長期保存し、EU AI Actの説明義務に備える |

| 5. 人材リスキリング | “AIオーケストレーター”育成 | Prompt設計+結果検証+コスト最適化を横断できるAI Flow Architectを社内ロールとして定義 |

パラダイムシフトの核心

- AIは「即答装置」から「熟考パートナー」へ――手戻りを減らし、人間は価値判断に集中。

- 性能×ガバナンスの複眼競争――透明性を巡る規制対応が新たな差別化要因。

- インフラ主導のコスト破壊――専用ASICと再エネDCで“深く考えるAI”が定額化する未来。

結論

o3-proは“熟考”を武器にAI活用の最前線を数年先取りしました。今後はGPT-5以降への統合で高速化・低コスト化が進み、「深く考える能力」があらゆる業務の標準機能になります。いま取るべきは、リスクに応じたハイブリッド運用と透明性確保の制度設計です。――“遅くてもいいから確実に考える”AIを味方につけ、次の競争フェーズへの橋頭保を築きましょう。

ただ・・・

まだまだAIで収益化する方法についてお伝えしたいことがたくさんあります。

じゅんの公式LINEでは、

- インスタアフィで稼ぐロードマップ

- 収益化に向けた詳しいノウハウ

- 各種テンプレート

などを中心に、

今回お伝えできなかったインスタ収益化ノウハウも

余すことなくお伝えしています。

お手元のスマートフォンが副収入を生み出すようになったら・・・

最高じゃありませんか…?

まずは僕の公式LINEを追加していただき、

ぜひ期間限定のインスタ収益化ノウハウをお受け取りください!

無料特典なので、早期に配布を終了することがあります。

\無料!登録10秒/

公式LINEに登録するだけで

インスタ初心者でも月6桁目指せる

豪華17大特典配布中🎁

登録解除は、24時間いつでも出来ます🙆♂️